Det 21. århundre har vært vitne til at AI (kunstig intelligens) utfører oppgaver som å slå mennesker lett ved sjakk eller lære dem fremmedspråk raskt.

En mer avansert oppgave for datamaskinen vil være å forutsi sannsynligheten for en lovbryter for å begå en annen forbrytelse. Det er jobben for et AI-system kalt COMPAS (Correctional Offender Management Profiling for Alternative Sanctions). Men det viser seg at verktøyet ikke er bedre enn en gjennomsnittlig fyr, og kan også være rasistisk. Vel, det er akkurat det et forskerteam har oppdaget etter å ha studert AI-systemet grundig, som er mye brukt av rettsinstitusjoner.

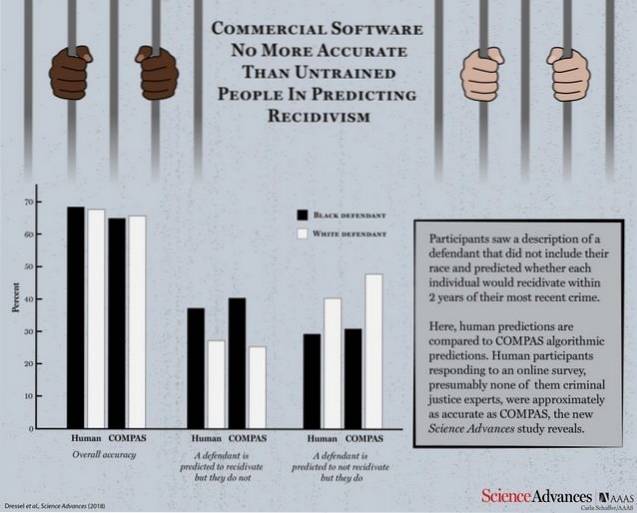

I følge en forskningsartikkel utgitt av Science Advances, ble COMPAS stilt opp mot en gruppe menneskelige deltakere for å teste effektiviteten og sjekke hvor godt det går mot de logiske spådommene fra en normal person. Maskinen og de menneskelige deltakerne fikk 1000 testbeskrivelser som inneholder alder, tidligere forbrytelser, kjønn etc. av lovbrytere hvis sannsynlighet for gjentatte forbrytelser skulle forutsies.

Med betydelig mindre informasjon enn COMPAS (bare 7 funksjoner sammenlignet med COMPAS 137), er en liten mengde av ikke-eksperter like nøyaktige som COMPAS når det gjelder å forutsi tilbakevendende.

COMPAS klokket en total nøyaktighet på 65,4% i å forutsi tilbakefall (tendensen til en dømt kriminell til å fornærme), noe som er mindre enn den kollektive spådomsnøyaktigheten til menneskelige deltakere som står på 67%.

Nå er det bare å ta et øyeblikk og reflektere i tankene dine at AI-systemet, som ikke gjør det bedre enn en gjennomsnittlig person, ble brukt av domstolene for å forutsi tilbakefall.

Kommersiell programvare som er mye brukt til å forutsi tilbakefall er ikke mer nøyaktig eller rettferdig enn spådommer fra mennesker med liten eller ingen strafferettsekspertise som svarte på en online undersøkelse.

Det som er enda verre er det faktum at systemet ble funnet å være like utsatt for rasefordommer som dets menneskelige kolleger da de ble bedt om å forutsi sannsynligheten for tilbakefall fra beskrivelser som også inneholdt raseinformasjon om lovbryterne. Du bør ikke bli for overrasket der, ettersom AI er kjent for å ta på seg mønstrene som menneskelige lærere vil programmere den til å lære.

Selv om begge sider faller drastisk under å oppnå en akseptabel nøyaktighetspoeng, reiser poenget med å bruke et AI-verktøy som ikke er bedre enn et gjennomsnittlig menneske mange spørsmål.

Gadgetshowto

Gadgetshowto